به جرات می توان داده را به منزله طلای جدید در هزاره سوم در نظر گرفت که برای استخراج آن نیاز به ماشین آلات خاصی است که می بایست هم به درستی انتخاب شوند و هم به درستی بکار گرفته شوند . تجزیه و تحلیل ، امکانات و تجهیزات لازم جهت استخراج رگه های طلا در معادن داده را فراهم می نماید . تجزیه و تحلیل داده می بایست تابع یک فرآیند منسجم باشد و این فرآیند ملزم به تبعیت از یک چرخه حیات معتبر . تاکنون چرخه های حیات متعددی به منظور تجزیه و تحلیل داده و داده کاوی ارایه شده است . به عنوان نمونه می توان به مدل فرآیندی داده کاوی

CRISP-DM ( برگرفته شده از

Cross Industry Standard Process for Data Mining ) اشاره کرد که با پیش بینی شش مرحله شناخت کسب وکار، شناخت داده ، آماده سازی داده ، مدل سازی ، ارزیابی و استقرار به دنبال ارایه یک مدل فرآیندی داده کاوی مستقل از یک صنعت بخصوص است . همچنین شرکت

IBM در سال 2015 مدل یکپارچه

ASUM-DM ( برگرفته شده از

Analytics Solutions Unified Method for Data Mining/Predictive ) که به نوعی توسعه یافته مدل

CRISP-DM می باشد را ارایه کرده است .

در مجموعه مقالاتی که با عنوان چرخه حیات تجزیه و تحلیل داده آماده شده است ، هدف آشنایی با یکی از چرخه های حیات معتبر به منظور تجزیه و تحلیل داده با تمرکز بر روی کلان داده ها و یا داده های عظیم است . در

بخش اول به کلیات این چرخه اشاره گردید . چرخه حیات فوق از شش مرحله مهم و استراتژیک تشکیل شده است که در ذیل هر مرحله مجموعه ای از فعالیت ها تعریف می شود . در

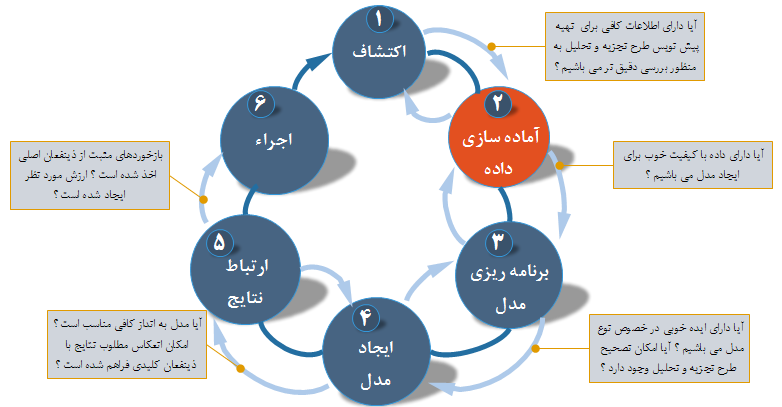

بخش دوم با تمرکز بر روی اولین مرحله چرخه حیات که از آن با نام کشف داده یاد می شود ، با مجموعه فعالیت های آن آشنا شدیم . در این بخش با تمرکز بر روی دومین مرحله چرخه حیات تجزیه و تحلیل داده که از آن با نام آماده سازی داده نام برده می شود با مجموعه فعالیت های آن آشنا خواهیم شد. در شکل 1 مراحل مختلف چرخه حیات تجزیه و تحلیل داده با تمرکز بر دومین مرحله نشان داده شده است .

شکل 1 : مراحل مختلف چرخه حیات تجزیه و تحلیل داده

شکل 1 : مراحل مختلف چرخه حیات تجزیه و تحلیل داده

مرحله دوم : آماده سازی داده

آماده سازی داده ، دومین مرحله چرخه حیات تجزیه و تحلیل است . بررسی ، پیش پردازش و تهویه داده قبل از مدل سازی و تجزیه و تحلیل از جمله مهمترین اهداف این مرحله می باشد. تیم داده برای نیل به اهداف خود به یک محیط مستحکم جهت بررسی داده که جدای از محیط تولید باشد ، نیاز خواهد داشت . معمولا این کار با آماده سازی یک محیط اولیه جهت بررسی داده که به آن ساندباکس

(Sandbox) گفته می شود ، آغاز می گردد . شناخت داده همراه با جزئیات لازم ، یکی از معیارهای کلیدی موفقیت یک پروژه تجزیه و تحلیل است . تصمیم گیری در خصوص نحوه تهویه داده و تبدیل به قالبی که بتوان از آن در تجزیه و تحلیل های آتی استفاده کرد از جمله مهمترین وظایف تیم داده در این مرحله است . در طی این مرحله و به منظور شناخت بهتر داده ( آشنایی عمیق تر با روند داده ، سنجش ارتباط بین متغیرهای داده ) ، تیم داده ممکن است از امکانات متنوعی جهت بصری سازی داده نیز استفاده نماید .

مرحله آماده سازی داده یکی از فشرده ترین کارها در چرخه حیات تجزیه و تحلیل داده است و می بایست بر روی انجام شدن درست و دقیق آن حساسیت مضاعفی به خرج داد. به جرات می توان گفت که حداقل 50 % زمان کل پروژه صرف کار در این مرحله می شود . در صورتی که تیم داده نتواند به اندازه کافی داده با کیفیت را بدست آورد ، ممکن است نتوان مراحل بعدی در چرخه حیات را دنبال کرد و در عمل تمامی پروژه با مشکل مواجه گردد .

همانگونه در شکل 1 نشان داده شده است ، مرحله آماده سازی داده یکی از فعالیت های تکرارشونده است که اعضاء تیم تمایل دارند با تاکید مضاعف بر روی آن به یک شناخت عمیق تر نسبت به وضعیت داده دست پیدا نمایند . چراکه اکثر تیم ها و رهبران مشتاق هستند تحلیل داده ، تست فرضیه ها و یافتن پاسخ به سوالات مطرح شده در فاز یک را پیدا نمایند . بسیاری از تیم های داده تمایل دارند که به سرعت وارد مراحل سوم و چهارم چرخه شده و مدل ها و الگوریتم هایی را ایجاد نمایند . همین شتاب و تعجیل در برخی موارد باعث می شود که جهت آماده سازی داده که دارای جایگاهی حیاتی در مدل سازی داده است ، زمان لازم در نظر گرفته نشود . در صورتی که تیم داده به این نتیجه برسند که امکان ایجاد و اجرای مدل با توجه به وضعیت موجود داده وجود ندارد ، می بایست در مقابل حرکت به مرحله بعدی ، به مرحله قبل حرکت نمایند و با رویکرد جدید دیگری که نشات گرفته شده از واقعیت موجود داده است ، فرضیات خود را شکل دهند.

شکل 2 ، مهمترین فعالیت های مرحله دوم چرخه حیات تجزیه و تحلیل را نشان می دهد .

شکل 2 : فعالیت های مرحله آماده سازی داده چرخه تجزیه و تحلیل داده

شکل 2 : فعالیت های مرحله آماده سازی داده چرخه تجزیه و تحلیل داده

در ادامه به هر یک از فعالیت های مرحله آماده سازی داده چرخه تجزیه و تحلیل اشاره می گردد .

آماده سازی محیط کاری تجزیه و تحلیل

اولین فعالیت از مجموعه فعالیت های فرآیند آماده سازی داده، تهیه یک محیط کاری تجزیه و تحلیل موسوم به ساندباکس است تا تیم داده بتواند وضعیت داده را بدون درگیر شدن مستقیم با بانک های اطلاعاتی محیط های تولیدی و زیربار بررسی نماید. فرض کنید تیم داده نیاز به کار با داده مالی یک سازمان داشته باشد. دستیابی و کار مستقیم با این نوع داده ها در حالی که سیستم ها زیربار و مشغول به ارایه خدمات می باشند ، می تواند چالش هایی را به دنبال داشته باشد . در چنین مواردی، هدف حذف تعامل مستقیم با نسخه های بانک های اطلاعاتی محیط های تولیدی و درگیر شدن با نسخه هایی است که بر اساس فرآیندهایی تدوین شده به محیط ساندباکس منتقل می شوند تا بتوان ارزیابی و کار اولیه بر روی داده جهت ایجاد شناخت عمیق تر نسبت به وضعیت موجود داده را انجام داد .

در

زمان ایجاد یک ساندباکس تجزیه و تحلیل ، توصیه می گردد تمامی نوع های داده در آن مکان جمع آوری گردد تا اعضاء تیم قادر به دستیابی به حجم بالای داده و گونه های مختلف داده جهت یک پروژه تجزیه وتحلیل در حوزه کلان داده ها باشند . در ساندباکس مورد نظر می توان هر نوع داده یی را قرار داد . از داده ساختیافته گرفته تا فیلدهای داده خام و داده غیرساختیافته .

این که چه میزان داده و یا چه نوع هایی را درون ساندباکس قرار داد ، جای بحث دارد و در برخی موارد هم مناقشه بین تیم داده و تیم فناوری اطلاعات . تیم های فناوری اطلاعات تمایل دارند که صرفا امکان دستیابی به بخشی از داده و جهت یک هدف بخصوص را فراهم نمایند ( رویکرد ارایه حداقل داده مورد نیاز به تیم داده جهت نیل به اهداف تعریف شده ) . در مقابل تیم داده تمایل دارند به هر چیزی دستیابی داشته باشند . از دید آنها داده بیشتر همواره می تواند نتایج مطلوب تری را به دنبال داشته باشد . به باور کارشناسان داده ، پروژه های علم داده ترکیبی از تحلیل های هدف محور و رویکردهای تجربی برای تست ایده های متنوع می باشند . تعامل تیم داده ، تیم فناوری اطلاعات و مالکین داده بسیار حیاتی است و همسویی مثبت و هدفمند می بایست بین آنها ایجاد گردد . ساندباکس تجزیه و تحلیل با انبار داده های نظارت شده متفاوت است و سازمان ها به کمک ساندباکس تجزیه و تحلیل قادر به انجام پروژه های داده بیش تری خواهند شد و از تجزیه و تحلیل سنتی به سمت هوش کسب و کار جهت تحلیل های پیشگویانه پیشرفته حرکت خواهند کرد . این که چه میزان داده را در ساندباکس تجمیع کرد جای بحث دارد . به

هر حال اندازه ساندباکس ، ارتباط مستقیم با پروژه دارد . با این که مفهوم استفاده از ساندباکس تجزیه و تحلیل نسبتا جدید به نظر می آید ولی هم اینک بسیاری از سازمان ها به دنبال یافتن روش هایی برای ارایه محیط های کاری جدید می باشند تا تیم داده بتواند به مجموعه داده های مورد نیاز دستیابی و با آنها کار کند ( قابل قبول برای تیم داده و تیم فناوری اطلاعات ).

انجام ETLT

برای کار با منابع داده می بایست محیط کاری ایجاد شده دارای پهنای باند مناسب و اتصالات مطمئن شبکه باشد تا فرآیند خواندن و نوشتن داده بدون وقفه دنبال گردد . در

ETL (برگرفته شده از

Extract, Transform, Load ) سه فرآیند استخراج ، تبدیل و بارگذاری انجام می شود . داده از منابع داده مبدا استخراج می گردد ، تبدیلات لازم و مورد نظر متناسب با مدل داده مقصد بر روی آن اعمال گردد و در نهایت داده در مخزن داده مقصد بارگذاری می گردد . در

ELT اولویت سه فرآیند اشاره شده نسبت به

ETL متفاوت است . در فرآیند فوق داده ابتدا استخراج می گردد ، سپس بارگذاری و در نهایت بر روی آن تبدیلات لازم انجام خواهد شد .

در ساندباکس تجزیه و تحلیل در بسیاری از موارد ترجیح داده می شود که داده با همان وضعیت اولیه ای که از منابع داده مبداء استخراج شده است ، در مخزن داده مقصد بارگذاری شود . در این مقطع ، تحلیل گران داده تصمیم خواهند گرفت که آیا لازم است داده را به وضعیت جدیدی تبدیل نمایند و یا آن را با همان حالتی که از منبع مبداء خوانده اند رها کرده و تحلیل های خود را انجام دهند. شاید ارزش مشهودی موجود در داده خام مهمترین دلیل در استخراج و بارگذاری داده در ساندباکس تجزیه و تحلیل قبل از هرگونه تبدیل باشد .

به عنوان نمونه ، فرض کنید یک تحلیل گر درگیر بررسی کشف تقلب در خصوص استفاده از کارت های اعتباری است . در موارد زیادی ممکن است تراکنش هایی با ریسک بالا که نشان دهنده فعالیت کارت های اعتباری غیرمجاز است ، در منابع داده مبداء ثبت شده باشد . در صورتی که از مجموعه فرآیندهای

ETL استفاده گردد ، ممکن است بسیاری از الگوهای فوق فیلتر شوند و یا عملیات تبدیل روی آنها انجام شود و یا درگیر فرآیند تمیزکاری داده شوند و عملا درون بانک اطلاعاتی مقصد بارگذاری نشود. به منظور بررسی الگوهای تقلب و تراکنش های جعلی نیاز به حجم زیادی از داده است که ممکن است در فرآیند

E از مجموعه فرآیندهای

ETL ، فیلتر گردند و عملا توان تیم داده جهت تحلیل مطلوب داده با توجه به احتمال تبدیل و یا حذف الگوهای تراکنش های جعلی ، کاهش یابد .

به تلفیق فرآیندهای

ETL و

ELT اصطلاحا

ETLT گفته می شود تا تاکیدی باشد بر این موضوع که تیم داده ممکن است در یک مورد از فرآیند

ETL و در مورد دیگر از فرآیند

ELT استفاده نماید .

انتقال داده درون محیط کاری یا همان ساندباکس تجزیه و تحلیل از دیگر موارد مهم مطرح در این مرحله است . تیم داده ممکن است تصمیم بگیرد که انتقال داده درون ساندباکس می بایست به صورت موازی انجام شود . در چنین مواردی به مجموعه فرآیندهای

ETL اصطلاحا

Big ETL گفته می شود و می توان با بکارگیری فرآیندهایی نظیرهدوپ یا

MapReduce این کار را انجام داد . توجه داشته باشید که از فناوری های فوق می توان برای پردازش و یا هضم داده به صورت موازی نیز استفاده کرد .

یکی از مواردی که می بایست در خصوص آن تصمیم گیری کرد پاسخ به این پرسش است که آیا لازم است پس از استخراج داده از منابع مبداء برروی آن تبدیلات خاصی انجام شود؟ برای پاسخ به سوال فوق باید با یک چشم به مدل داده مقصد نگاهی داشت و با چشم دیگر وضعیت کیفیت داده استخراج شده از منابع مبداء را ارزیابی کرد . در صورتی که مدل داده مقصد شرایط را بگونه ای تعیین کرده باشد که نیاز به داده هایی با کیفیت و قالب خاص باشد ، عملیات تبدیل پس از استخراج و قبل از بارگذاری انجام خواهد گرفت .

رابط برنامه نویسی یا

API یک روش متداول جهت دستیابی به منابع داده دلخواه دیگر متناسب با اهداف یک پروژه است . هم اینک تعداد زیادی از وب سایت ها و برنامه های شبکه های اجتماعی رابط های برنامه نویسی (

APIs ) متنوعی را به منظور حمایت از یک پروژه یا مکمل مجموعه داده هایی که تیم داده با آنها کار می کند را ارایه کرده اند . به عنوان نمونه، یک تیم داده می تواند با اتصال به

API توئیتر از میلیون ها توئیت ثبت شده برای انجام یک پروژه و یا تحلیل نظرات ثبت شده در خصوص یک محصول ، یک شرکت و یا یک ایده استفاده نماید . امکان دستیابی عمومی به اکثر داده ثبت شده در توئیتر وجود دارد و می

توان با استفاده و قرار دادن آنها در کنار سایر مجموعه های داده ، پروژه را تقویت کرد .

یادگیری در مورد داده

یکی از جنبه های حیاتی یک پروژه علم داده آشنایی با خود داده است . شناخت دقیق و ظریف مجموعه های داده (دیتاست ها ) باعث می شود که بین وضعیت موجود داده و انتظارات از آن ، یک توازن منطقی برقرار گردد. توازنی که باعث می شود ضمن عدم رویا پردازی با توقعات منطقی به انتظار خروجی و یافته های یک پروژه نشست . علاوه بر این

، ضروری است تمامی منابع داده ئی که تیم داده به آنها دستیابی دارند مستند شوند . همچنین ، می بایست شناسایی منابع داده اضافه ای که تیم داده می تواند در جهت تقویت کار از آنها استفاده نماید ولی هم اینک امکان دستیابی به آنها وجود ندارد در دستور کار قرار بگیرد. برخی از فعالیت های این مرحله ممکن است با بررسی اولیه مجموعه های داده در مرحله اکتشاف داده هم پوشانی داشته باشد . انجام این فعالیت ها با اهداف زیر انجام می شود :

- شفاف سازی دقیق داده هایی که در آغاز به کار پروژه ، تیم داده به آنها دستیابی دارد .

- شناسایی مجموعه های داده درون سازمان که تیم داده آنها را مفید تشخیص داده است ولی به دلایلی امکان دستیابی به آنها وجود ندارد ( ارزیابی فاصله موجود).

- شناسایی مجموعه داده های خارج از سازمان که از منظر تیم داده دستیابی به آنها می تواند در انجام موفقیت آمیز پروژه کمک قابل توجهی داشته باشد . این کار از طریق رابط های برنامه نویسی ، اشتراک داده ، خرید داده انجام خواهد شد تا بتوان از آنها به عنوان مکمل مجموعه داده های موجود در انجام پروژه استفاده کرد .

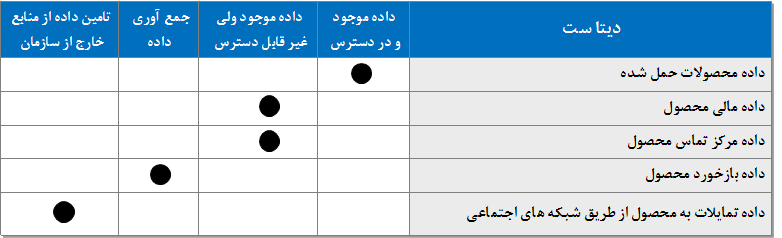

شکل 3 ، یک لیست نمونه موجودی داده را نشان می دهد .

شکل 3 : یک لیست نمونه از موجودی داده

شکل 3 : یک لیست نمونه از موجودی داده

تهویه داده

به فرآیند تمیز کردن داده ، نرمالیزه کردن مجموعه های داده ( دیتا ست ها ) و تبدیلات مورد نظر بر روی داده اصطلاحا تهویه داده گفته می شود . فعالیت فوق یکی از حیاتی ترین عملیات در چرخه حیات تجزیه و تحلیل است که شامل مراحل پیچیده زیادی نظیر تلفیق مجموعه های داده و قرار دادن مجموعه های داده در وضعیتی است که بتوان از آنها در مراحل بعدی تجزیه و تحلیل استفاده کرد . اغلب

، فرآیند تهویه داده به عنوان یک مرحله پیش پردازش برای تحلیل داده در نظر گرفته می شود چراکه مستلزم انجام عملیات زیادی بر روی مجموعه های داده قبل از ایجاد مدل ها است . فرآیند تهویه داده با مشارکت و همکاری بین تیم های فناوری اطلاعات ، مالکین داده ، مدیر بانک اطلاعاتی و مهندسین داده انجام می شود . توصیه شده است که در این مرحله دانشمندان داده نیز درگیر این فرآیند گردند چراکه تصمیمات زیادی در مرحله تهویه داده اتخاذ خواهد شد که می تواند بر تحلیل های بعدی تاثیرگذار باشد . تصمیم گیری مبتنی بر مشارکت تمامی بازیگران ، احتمال موفقیت یک پروژه را به شدت افزایش خواهد . واگذاری

این نوع تصمیمات به یک فرد ، باعث می شود که در مراحل بعدی چرخه مجبور شویم به مراحل پیشین برگردیم و داده هایی را که به هر دلیل کنار گذاشته ایم ، مجددا بررسی کنیم .

انتخاب و یا عدم انتخاب داده برای انجام یک پروژه بسیار حیاتی است . معمولا تیم داده ترجیح می دهد با داده بیشتری قدم در مرحله تحلیل بگذارد. در خصوص فرآیند تهویه داده سوالات متعددی مطرح می گردد که پاسخ گویی صحیح و دقیق به آنها باعث می شود حرکت به سمت گام بعدی چرخه حیات تجزیه و تحلیل با صلابت بیشتری صورت پذیرد .

- چه منابع داده ئی را در اختیار داریم ؟ فیلدهای هدف ، کدام فیلدها می باشند ؟ ( به عنوان نمونه ستون هایی از جداول )

- وضعیت کیفیت داده ها به چه صورت است ؟ سطوح مختلف کیفیت داده می بایست به دقت تعیین گردند .

- وضعیت سازگاری محتویات و فایل ها به چه صورت است ؟ سطوح مختلف ناسازگاری می بایست داده به دقت تعیین گردند .( مقادیر نادرست ، مقادیر حذف شده و... )

- وضعیت سازگاری نوع های داده به چه صورت است ؟ به عنوان نمونه اگر تیم داده این انتظار را دارد که نوع های خاصی از داده عددی باشند ، این موضوع می بایست بررسی و صحت آن مورد تایید قرار گیرد .

- محتویات ستون های داده و یا سایر ورودی ها به منظور اطمینان از معنی دار بودن مقادیر به دقت بررسی گردد . به عنوان نمونه اگر قرار است تحلیل سطح درآمد انجام شود .آیا قابل قبول خواهد بود که مقادیر صفر و یا منفی در ستون های مربوطه وجود داشته باشد ؟

- بررسی شهودی هر نوع خطای سیستماتیک نظیر تغذیه داده نادرست توسط حسگرها و یا سایر منابع تامین کننده داده که باعث ورود داده نادرست و یا غیرمعتبر به درون مجموعه های داده می شود می بایست به دقت بررسی گردد.

بصری سازی و بررسی اولیه

پس از جمع آوری و به دست آوردن حداقل داده مورد نیاز جهت تحلیل در مراحل بعدی ، بصری سازی داده جهت بررسی

و مرور اولیه داده به کمک ابزارهای موجود می تواند بسیار مفید و کارساز باشد . مشاهده الگوهای سطح بالا در داده این امکان را فراهم می نماید تا بتوان با سرعت بیشتری با ویژگی های داده آشنا گردید . به عنوان مثال با بررسی کیفیت داده و بصری سازی وضعیت آن می توان به سرعت تشخیص داد که آیا داده مورد نظر شامل مقادیری خارج از انتظار است و بتوان وضعیت کیفیت داده را متناسب با شاخص های تعریف شده بررسی کرد . با بررسی اولیه و متعاقب آن تمرکز و فیلترکردن می توان با استفاده از یک رویکرد عمل گرایانه برای بصری سازی تحلیل داده به سرعت نقاط مثبت و منفی کار را مشاهده کرد و اطلاعاتی با جزئیات بیشتر در خصوص یک حوزه خاص داده کسب کرد . برای بررسی و انتخاب ابزارهای بصری سازی داده توجه به برخی نکات ضروری است :

- بررسی داده با هدف اطمینان از این موضوع که ستون ها و مقادیر یک فیلد بخصوص در بین جداول مختلف سازگار می باشند .

- آیا توزیع داده در بین تمامی مجموعه های داده سازگار باقی می ماند ؟در صورتی که پاسخ منفی است ، چه اقدام و یا اقداماتی را می بایست انجام داد؟

- بررسی محدوده مقادیر و سطح تجمیع داده

- آیا داده استاندارد شده و نرمالیزه شده است ؟

ابزارهای لازم برای آماده سازی داده

برای آماده سازی داده از ابزارهای متعددی می توان استفاده کرد :

- هدوپ : از هدوپ می توان به منظور پردازش موازی ، تحلیل های سفارشی ، تحلیل مکانی و موارد مشابه دیگر استفاده کرد.

- OpenRefine : یک نرم افزار کد باز قدرتمند برای کار با داده ها است . نرم افزار فوق دارای یک رابط کاربر گرافیکی جهت انجام تبدیلات داده و یکی از قوی ترین ابزارهای رایگان موجود است .

- همانند OpenRefine، نرم افزار Data Wrangler یک ابزار محاوره ای برای تمیزکاری داده و تبدیل است . این نرم افزار توسط دانشگاه استنفورد طراحی شده است و می توان از آن برای انجام هر گونه تبدیل و بر روی هر نوع dataset استفاده کرد . علاوه براین ، می توان از خروجی های تولید شده در جاوا و یا پایتون نیز استفاده کرد .

موفقیت در مرحله دوم چرخه حیات تجزیه و تحلیل داده مستلزم همکاری و تعامل نزدیک بین تیم داده ، فناوری اطلاعات ، مدیران بانک های اطلاعاتی و مالکین داده است .

خلاصه

تجزیه و تحلیل داده می بایست تابع یک فرآیند حاکمیتی باشد و این فرآیند ملزم به تبعیت از یک چرخه حیات معتبر. تاکنون چرخه های حیات متعددی به منظور تجزیه و تحلیل داده ارایه شده است . در

بخش اول به یکی از این چرخه های حیات با تمرکز بر روی کلان داده ها و یا داده های عظیم اشاره گردید . چرخه حیات فوق از شش مرحله مهم و استراتژیک تشکیل شده است که در ذیل هر مرحله مجموعه ای از فعالیت ها تعریف می شود . در

بخش دوم با تمرکز بر روی اولین مرحله چرخه حیات که از آن با نام کشف داده یاد می شود ، با مجموعه فعالیت های آن آشنا شدیم . در این بخش به مجموعه فعالیت های مرحله دوم چرخه حیات تجزیه و تحلیل داده که از آن با نام مرحله آماده سازی داده نام برده می شود اشاره گردید . آماده سازی یک محیط کاری مناسب جهت تجزیه و تحلیل داده ، انجام فرآیندهای

ETLT ، تمرکز بر روی خود داده و شناخت عمیق تر آن ، تهویه داده ، بررسی

و بصری سازی و در نهایت ابزارهای لازم جهت آماده سازی داده از جمله فعالیت های مهم در ذیل فرآیند آماده سازی داده چرخه حیات تجزیه و تحلیل داده می باشند .

در بخش بعد به سراغ مرحله سوم چرخه حیات تجزیه و تحلیل داده خواهیم رفت و با مجموعه فعالیت های لازم جهت برنامه ریزی مدل آشنا خواهیم شد .

منابع :

EMC Education Services. Data Science and Big Data Analytics: Discovering, Analyzing, Visualizing and Presenting Data. Wiley, 2015

Bart Baesens,Analytics in a Big Data World: The Essential Guide to Data Science and its Applications. Wiley, 2014

Rachel Alt-Simmons,Agile by Design: An Implementation Guide to Analytic Lifecycle Management,Wiley, 2014